Muchas de las mentes más brillantes del planeta llevan advirtiendo últimamente que estamos ante una nueva revolución en la historia de la civilización, que será más profunda aún que cualquiera de las revoluciones industriales precedentes y que llegará por causa de la Inteligencia Artificial. Algunos expertos son cortoplacistas (20 años) debido al progreso tecnológico exponencial, otros también especialistas en el tema, no lo ven antes de 50-70 años. Unos optimistas y otros más pesimistas sobre las consecuencias, pero todos coinciden en que la humanidad se encamina irremediablemente a un futuro impredecible, algunos lo llaman singularidad (el momento de cambio en el que la inteligencia de las máquinas sea mayor que la del humano), que hará cambiar todos los esquemas sociales actuales. Desde los sistemas económicos, mercados de trabajo, sistemas de producción, comunicación, hasta las relaciones las relaciones humanas (sobre esto recomiendo ver la película Her). Pero ¿qué es la Inteligencia Artificial? ¿Qué entendemos por IA? Lo mejor, repasarlo desde el comienzo.

Muchas de las mentes más brillantes del planeta llevan advirtiendo últimamente que estamos ante una nueva revolución en la historia de la civilización, que será más profunda aún que cualquiera de las revoluciones industriales precedentes y que llegará por causa de la Inteligencia Artificial. Algunos expertos son cortoplacistas (20 años) debido al progreso tecnológico exponencial, otros también especialistas en el tema, no lo ven antes de 50-70 años. Unos optimistas y otros más pesimistas sobre las consecuencias, pero todos coinciden en que la humanidad se encamina irremediablemente a un futuro impredecible, algunos lo llaman singularidad (el momento de cambio en el que la inteligencia de las máquinas sea mayor que la del humano), que hará cambiar todos los esquemas sociales actuales. Desde los sistemas económicos, mercados de trabajo, sistemas de producción, comunicación, hasta las relaciones las relaciones humanas (sobre esto recomiendo ver la película Her). Pero ¿qué es la Inteligencia Artificial? ¿Qué entendemos por IA? Lo mejor, repasarlo desde el comienzo.

Un poco de historia

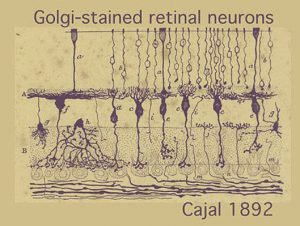

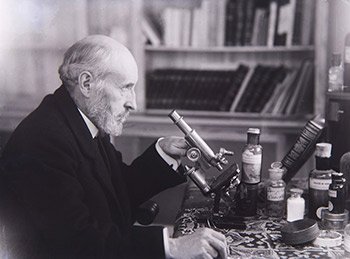

La historia comienza con Santiago Ramón y Cajal (1852-1934), el gran neuroanatomista español quien descubrió las neuronas en el cerebro, son individuales y están interconectadas. Anteriormente la creencia era que el cerebro era una especie de red continua de cables conectados pero no había una explicación clara. Incluso la teoría de las células neuronales era novedosa en aquel tiempo. El neurocientífico premiado con el Nobel dibujó numerosos diagramas de diferentes tipos de neuronas que aún hoy, 125 años después son incomparables.

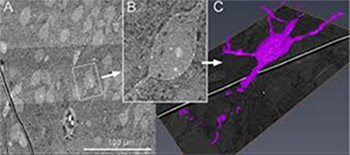

Desde entonces se ha trabajado mucho en laboratorios de investigación por todo el mundo, como el Max Planck Institute, realizando cortes seccionados muy finos de cerebros de ratones y tomando instantáneas con microscopios de electrones obteniendo unas imágenes muy similares a las de Cajal.

El número de neuronas que alberga el cerebro y la complejidad de procesos que interconectan unas con otras es realmente asombroso, pudiendo hacer que toda las inteligencia de cada individuo quepa en ese espacio tan reducido dentro del cráneo.

El número de neuronas que alberga el cerebro y la complejidad de procesos que interconectan unas con otras es realmente asombroso, pudiendo hacer que toda las inteligencia de cada individuo quepa en ese espacio tan reducido dentro del cráneo.

Gracias ahora a la renderización en 3D podemos obtener imágenes y vídeos donde poder apreciar la abrumadora cantidad de conexiones neuronales. Este nuevo área de la ciencia todavía tiene un camino que recorrer hasta poder llegar a integrar las redes biológicas con redes neuronales artificiales, aunque personalmente creo que el día llegará, no está aún en el horizonte cercano, al menos tal y como vemos en las películas de ciencia ficción.

Gracias ahora a la renderización en 3D podemos obtener imágenes y vídeos donde poder apreciar la abrumadora cantidad de conexiones neuronales. Este nuevo área de la ciencia todavía tiene un camino que recorrer hasta poder llegar a integrar las redes biológicas con redes neuronales artificiales, aunque personalmente creo que el día llegará, no está aún en el horizonte cercano, al menos tal y como vemos en las películas de ciencia ficción.

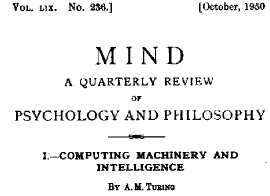

En 1948 Alan Turing presentó el modelo matemático que sirvió de base para la computación que usamos hoy en día en los dispositivos electrónicos. Se basaba en la lógica secuencial de programación, pero este no fue el único modelo que escribió Turing. Otro al que no se le dio tanta importancia en aquel momento fue un modelo de máquina no-organizada: redes neuronales. El título de su publicación en 1950 fue Máquinas Inteligentes. El objetivo era intentar explicar cómo las máquinas electrónicas pueden operar tal y como lo hacen nuestros cerebros, y describió las arquitecturas que serían necesarias para lograrlo, muy parecidas a las redes neuronales, con el conocimiento que había entonces.

Se basaba en la lógica secuencial de programación, pero este no fue el único modelo que escribió Turing. Otro al que no se le dio tanta importancia en aquel momento fue un modelo de máquina no-organizada: redes neuronales. El título de su publicación en 1950 fue Máquinas Inteligentes. El objetivo era intentar explicar cómo las máquinas electrónicas pueden operar tal y como lo hacen nuestros cerebros, y describió las arquitecturas que serían necesarias para lograrlo, muy parecidas a las redes neuronales, con el conocimiento que había entonces. Frank Rosenblatt construyó en 1960 una versión física de la máquina no-organizada de Turing a la que llamó Perceptron. Era capaz de reconocer figuras muy simples como triángulos, cuadrados y círculos, tareas de reconocimiento visual sencillas. Entonces se separaron los caminos.

Frank Rosenblatt construyó en 1960 una versión física de la máquina no-organizada de Turing a la que llamó Perceptron. Era capaz de reconocer figuras muy simples como triángulos, cuadrados y círculos, tareas de reconocimiento visual sencillas. Entonces se separaron los caminos.

Separación neurociencia y ciencia computacional tradicional

Los neurocientíficos seguidores de las teorías de Turing siguieron un camino que derivó al ostracismo y la ciencia de computación siguió otro.  Esta rama creó en Inglaterra el Manchester baby, considerado como el primer ordenador de programas almacenados, que siguiendo las calculadoras de bolsillo ha llegado hasta los portátiles y iPhones que usamos hoy día.

Esta rama creó en Inglaterra el Manchester baby, considerado como el primer ordenador de programas almacenados, que siguiendo las calculadoras de bolsillo ha llegado hasta los portátiles y iPhones que usamos hoy día.

La ingeniería neuronal tuvo un resurgimiento hace 10 años gracias al deep learning, muy de moda este último año en el mundo del big data. El deep learning es una vuelta a los modelos clásicos de máquinas no-organizadas de los modelos de Turing, e inicialmente perseguían únicamente analizar imágenes (como el Perceptron de hacía 50 años). El funcionamiento esencialmente es captar imágenes imaginando que la primera capa de las neuronas fueran fotoreceptores que conectan en la retina con otras capas de neuronas detrás del ojo, que a su vez conectan con otra capa de neuronas más alejadas, y así sucesivamente. Posteriormente, se realiza un entrenamiento para acometer una tarea mediante repetición de sinapsis o conexiones entre capas neuronales. Después del entrenamiento podemos observar cómo el modo en que responden a la luz las redes neuronales artificiales son muy similares a las respuestas que observamos en neuronas reales en la corteza cerebral. Estos sistemas de redes neuronales profundos (deep learning) son los que mejor funcionan de todos los sistemas de percepción investigados hasta la fecha y se comportan de manera muy similar a cómo los cerebros biológicos resuelven los problemas, lo que nos hace pensar que se está caminando en la dirección correcta para llegar a realizar con máquinas lo que hacen los cerebros.

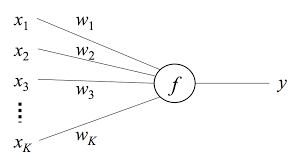

El funcionamiento del deep learning se basa en una fórmula muy simple («y = x * w»), tenemos inputs (x), el peso (w) que damos a la variable de entrada, y la variable de salida (y). El peso no lo conocemos, el truco para que funcione es jugar con esa variable, y es lo que se hace con el aprendizaje. Por esto cuanto más tiempo se entrene el sistema mejores son los resultados. El reconocimiento visual de fotos ha alcanzado tan nivel de sofisticación en tan poco tiempo que Google, por ejemplo, está experimentando entre otros con su producto Photos. Aplicando Inteligencia Artificial el modelo es capaz de identificar automáticamente personas que aparecen en una foto o el año en que fue tomada, simplemente observando pequeñas pistas como tipografía de señales, peinados o ropa de la gente que aparece en la foto. No conocemos realmente cuales son todas las pistas ya que no se le ha programado para ello, simplemente se le han dado muchas fotos de ejemplo (y) con el año correcto y es el sistema el que ha ido aprendiendo sólo. Es como si dijéramos aprender al revés, a partir del resultado buscamos patrones que coincidan con lo que se busca.

El funcionamiento del deep learning se basa en una fórmula muy simple («y = x * w»), tenemos inputs (x), el peso (w) que damos a la variable de entrada, y la variable de salida (y). El peso no lo conocemos, el truco para que funcione es jugar con esa variable, y es lo que se hace con el aprendizaje. Por esto cuanto más tiempo se entrene el sistema mejores son los resultados. El reconocimiento visual de fotos ha alcanzado tan nivel de sofisticación en tan poco tiempo que Google, por ejemplo, está experimentando entre otros con su producto Photos. Aplicando Inteligencia Artificial el modelo es capaz de identificar automáticamente personas que aparecen en una foto o el año en que fue tomada, simplemente observando pequeñas pistas como tipografía de señales, peinados o ropa de la gente que aparece en la foto. No conocemos realmente cuales son todas las pistas ya que no se le ha programado para ello, simplemente se le han dado muchas fotos de ejemplo (y) con el año correcto y es el sistema el que ha ido aprendiendo sólo. Es como si dijéramos aprender al revés, a partir del resultado buscamos patrones que coincidan con lo que se busca.

También se está experimentando con la creatividad, con curiosos ejemplos de inteligencia Artificial aplicada a la creación artística en el campo visual, musical, hasta en el literario, de momento con resultados muy discutibles pero sin duda se puede apreciar por donde avanzarán conceptualmente de la misma manera que evolucionaron las primeras expresiones creativas humanas.

¿Se ha alcanzado ya la inteligencia artificial?

Estos sistemas de redes neuronales imitan el comportamiento cerebral para desarrollar unas tareas específicas (narrow intelligence) pero todavía no se les puede llamar inteligentes (inteligencia general). No hay más que intentar tener una conversación con Siri (IA de Apple) para darse cuenta de ello. Pero sí creo que más pronto de lo que la mayoría de gente supone va a llegar un sistema que contenga todas las propiedades que presumimos en un ser dotado de inteligencia general. En un artículo próximo analizaremos las principales tecnologías utilizadas hoy y los principales usos prácticos en Inteligencia Artificial.

What do you think?

[…] de datos de entrenamiento para que resulten fiables. Como explicamos en un artículo previo, las redes reuronales artificiales fueron desarrolladas por investigadores que trataban de imitar el comportamiento neurofisiológico […]

Comments are closed.