Crear aplicaciones para el manejo de big data requiere concentrarse en las soluciones que permitan disponer de entornos para el manejo de data analytics sobre una infraestructura flexible, escalable, y segura. Si los datos todavía tienen un rol marginal en su empresa, aplicados solamente a algunos departamentos, dependiendo de sus necesidades de negocio y objetivos, quizá debería plantearse mover big data analytics al centro de su negocio. A continuación presentamos algunos consejos para la implantación de una estrategia big data que permita maximizar el retorno de la inversión e incrementar las posibilidades de éxito.

Consejo 1: Identifique la oportunidad de negocio

El fin de big data no es la tecnología, sino el negocio que permita generar y la mejora de rendimiento. Por tanto, es fundamental tener claras las necesidades de negocio y las demandas que tendrá antes de invertir el primer euro. El punto de arranque lógico para cualquier iniciativa es realizar un análisis inicial de situación, identificando necesidades, preguntas, oportunidades y objetivos con unos resultados medibles, como por ejemplo, el incremento de la satisfacción del cliente, los márgenes de beneficio o tomas de decisión más ágiles.

Antes que centrarse en la tecnología, debería preguntarse cómo la iniciativa ayudará a su organización a alcanzar los objetivos de negocio previamente definidos. Esta tarea puede realizarse internamente si dispone de los recursos adecuados o apoyado por una consultoría externa si el personal requiere de ayuda profesional. Se han de priorizar las oportunidades buscando el mayor potencial de lograr un gran impacto. A continuación se han de identificar las capacidades más críticas para los primeros casos de uso, incluyendo el software y los servicios que serán necesarios.

El volumen de datos y las opciones disponibles pueden resultar abrumadoras para los miembros del equipo encargado del proyecto, que pueden quedar fácilmente atados a determinadas tecnologías. Para evitarlo puede considerar trazar una hoja de ruta, que ayude a marcar el alcance del big data identificando los retos clave del negocio sobre los que se va a comenzar. Este mapa ayudará a consensuar cómo se usará el big data para mejorar el negocio y alcanzar los objetivos definidos. También tendrá en consideración los datos, tecnologías y habilidades existentes, y definirá por donde empezar y cómo desarrollar el plan alineando las estrategias de negocio y sistemas.

Para algunas organizaciones, una guía experta es indispensable para empezar a moverse en la dirección adecuada. Lo normal es que consultores externos ayuden en esta fase aconsejando qué es posible, desde una perspectiva independiente e imparcial. Deben conocer el impacto de los posibles escenarios y ayudar a articular una estrategia que incorpore a todas las partes involucradas de la empresa.

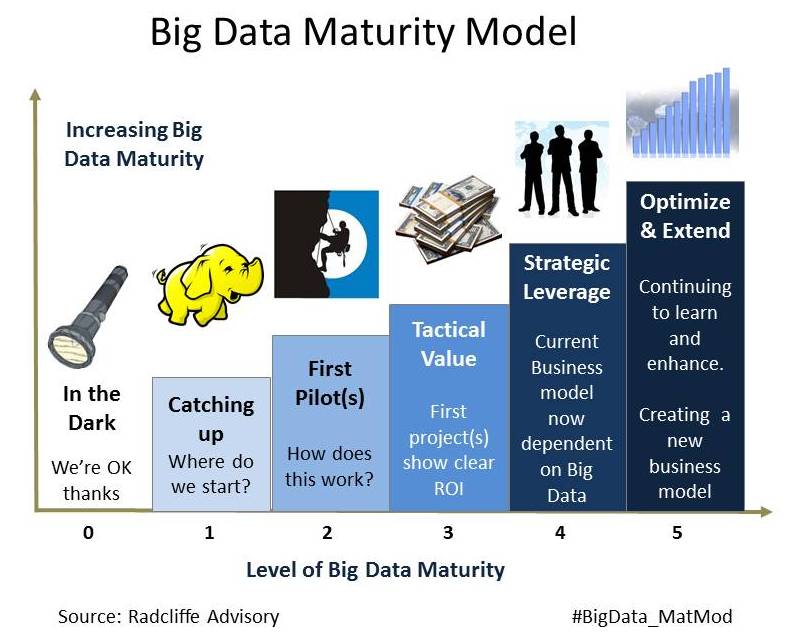

Consejo 2: Piensa a lo grande, pero comienza por lo pequeño

A la hora de trabajar con datos con los que la organización no ha trabajado antes genera incertidumbre. ¿Cuáles son los elementos entre todos los datos que poseen valor? Cuáles son las métricas más importantes que pueden generar los datos? Un ejemplo, realizar un piloto para extraer los ahorros de costes de los procesos financieros puede convertirse en un quick win que persuada a otros profesionales de la empresa a sumarse a reconocer el potencial del big data, y la necesidad de generar ideas para realizar más iniciativas en otras áreas de la empresa. Como los costes y el tiempo necesario para conseguir resultados satisfactorios pueden ser difíciles de estimar, tiene sentido empezar con hitos fáciles y rápidos. La idea es seguir un camino pero avanzando en pequeños pasos e ir incrementándolos poco a poco a medida que veamos lo que podemos conseguir gracias al análisis del big data, y cómo aplicarlo rápidamente a la empresa. Después, se pueden aplicar las lecciones aprendidas a iniciativas más ambiciosas en otras áreas.

Comienza haciendo lo que es necesario, después lo que es posible y de repente estarás haciendo lo imposible. San Francisco Asís

El consejo es empezar por definir unas pocas pero efectivas tareas de analytics que no lleven mucho tiempo ni requieran muchos datos. Por ejemplo, para conseguir más ingresos, una tienda online puede implementar una aplicación de recomendación de productos que genere automáticamente sugerencias personalizadas de productos, basadas en intereses actuales e históricos del cliente combinadas con tendencias generales y reglas de negocio predefinidas. Mediante el uso de técnicas ágiles de implementación nos va a permitir averiguar qué pueden hacer los datos en el negocio. Mediante el análisis de resultados en grupos de test y de control podremos analizar los resultados de forma inequívoca.

Los prototipos que tengan éxito además hacen que sea sencillo conseguir más apoyo para un esfuerzo mayor. Además, el siguiente paso tendrá menor riesgo ya que los participantes conocen cómo trabajar con los datos y el valor que aportan los datos está parcialmente probado.

Durante el proceso, los profesionales aprenderán mucho de los datos y de cómo trabajar con ellos. Evitar hacerlo muy complicado desde el principio, reduciendo el alcance a lo más sencillo posible con resultados efectivos, y desde ahí escalar a una solución más ambiciosa.

Consejo 3: Experimentar con diferentes enfoques

Los profesionales que trabajan en analytics normalmente sobresalen a la hora de medir la información correcta, pero se abruman cuando el volumen es enorme y la variedad creciente. En lugar de establecer unos procesos formales de captura, procesamiento y análisis de todos los datos todo el tiempo, lo que hacen es capturar un subconjunto de datos definidos, como por ejemplo, un mes de data para un departamento, producto o división en concreto.

El consejo es animar a la plantilla a reexaminar cada uno de los procesos y desarrollar la curiosidad necesaria para introducir analytics en otras áreas, no solamente se trata de actualizar las aplicaciones que tradicionalmente trabajan con datos, sino localizar áreas donde el big data pueda cambiar la forma de operar. Nos debemos preguntar, ¿puede analytics en tiempo real ayudar a generar más negocio? En principio podría parecer que el procesamiento de real-time analytics no debería suponer una gran diferencia. Sin embargo, estas capacidades han permitido la creación de nuevas líneas de negocio. Por ejemplo, proveedores de servicios de telecomunicaciones pueden analizar datos de localización de millones de dispositivos móviles para ofrecer a nuevos clientes con ofertas personalizadas, productos a medida, y campañas de marketing más efectivas que hacen incrementar las oportunidades de generar nuevos ingresos.

Otro consejo práctico es evaluar diferentes frameworks de aplicaciones para asegurarse que son los más adecuados para sus necesidades analíticas. Pregúntese, ¿es Hadoop la mejor alternativa para los datos que vamos a mover o deberíamos ir con Spark? Para aplicaciones que impliquen algoritmos de machine learning iteractivos e interacción con las analíticas, Spark ofrece algunas ventajas de rendimiento, incluye consultas de datos en tiempo real, stream processing, y procesamiento de sensores de datos. Hadoop, por otra parte, es la herramienta ideal para datos semi-estructurados, además de contar con la flexibilidad de MapReduce para hacer las queries. La plataforma ofrece computación distribuida y capacidades a un coste relativamente bajo.

También se ha considerar el expertise y el conjunto de herramientas actuales. Si disponemos de profesionales con experiencia en Hadoop, ¿es mejor aprovechar ese conocimiento, o el valor añadido que aporta Spark realmente compensa la inversión en nuevas capacidades y los workflows actualizados?

Consejo 4: Optimizar los recursos de sistemas

Uno de los mayores retos en los entornos analíticos distribuidos es que muchos frameworks de aplicaciones tienen sus propios planificadores de cargas de trabajo y operan bajo la presunción de correr en una infraestructura dedicada. El resultado puede provocar que los costosos silos de infraestructura de sistema estén subutilizados. Esto suele ocurrir en configuraciones experimentales donde cada grupo de trabajo lleva su framework o sus aplicaciones y hacen una configuración separada para cada cluster, ya que es lo más sencillo (o que tienen permitido).

En lugar de configurar diferentes servidores de clusters para diferentes aplicaciones, puede usar software de alto rendimiento que permita gestionar la red de sistemas para que las aplicaciones compartan recursos sin interferencia entre ellas. Este tipo de software puede destinar los recursos dinámicamente a medida que se van solicitando, y permite reducir los pasos a la hora de hacer despliegues y migraciones, manteniendo las tasas de operativo y tolerancia a fallos.

Al compartir recursos entre aplicaciones, los usuarios y las áreas de negocio pueden optimizar el hardware existente, mitigar la expansión de clusters y frenar así la necesidad de aumentar la inversión de sistemas. Además, gracias al reporting (informes de uso consolidados, información sobre planificación de capacidad, …) los administradores pueden monitorizar los recursos de manera más eficiente para cumplir con los niveles de servicio exigidos, y desplegar nuevos recursos más rápidamente a medida que sean necesarios.

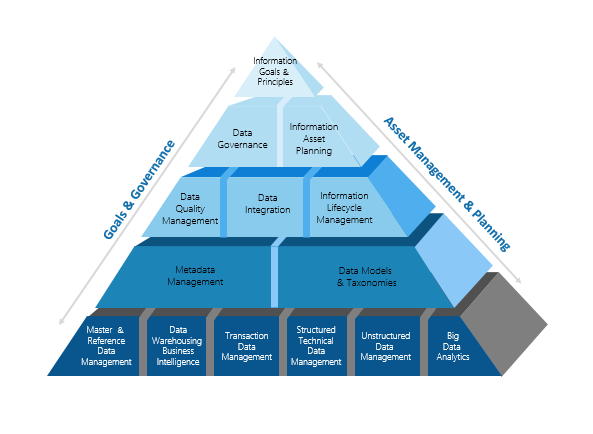

Consejo 5: No olvide la gestión de datos

Las cargas de trabajo de las aplicaciones big data analytics requieren de unos niveles muy exigentes en sistemas de infraestructuras con un nivel alto de rendimiento. Puede suponer un problema para organizaciones con picos de demanda inesperados, o necesidades de acceso a recursos de computación o almacenamiento adicionales para dar soporte a nuevos negocios.

Una solución reciente es SDI (software de infraestructura definida), un modelo por el cual los recursos en cloud pueden seer gestionados por software en lugar de operadores manuales. El funcionamiento de la infraestructura de aplicaciones que capta los requerimientos en cargas de trabajo y gracias a las best practices de despliegues previos, podemos conseguir un proceso automatizado basado en reglas definidas entre los diferentes entornos del data center.

De esta manera se optimizan las cargas de trabajo en tiempo real. Este funcionamiento (SDI) implica la separación de la gestión de datos del almacenamiento físico mediante una capa de virtualización. Este enfoque permite optimizar el almacenamiento mediante aprovisionamiento automático por niveles, y obtener una escalabilidad a menor coste en sistemas de almacenamiento heterogéneo que puede además estar geográficamente distribuido. Esta es la tendencia actual, un enfoque más orientado a servicios que a hardware de almacenamiento. El objetivo es dotar a los administradores de capacidades de gestión flexibles. Eliminando las barreras de sistemas físicos, un recurso de almacenamiento puede desplegarse mucho más eficientemente. La administración se simplifica con una interfaz de usuario unificada y la gestión del sistema de reglas de funcionamiento para el pool compartido.

Consejo 6: Construir sobre los éxitos conseguidos

Una vez los pilotos han sido probados, el paso siguiente es escalar el big data y el análisis de los datos a otras áreas de la organización. En lugar de empezar de cero cada vez, podemos ir gestionando los resultados previos para emplear métodos y acciones como referencia y reutilización. Este ciclo iterativo de «agitar y repetir» donde se vuelve al primer paso de identificación de oportunidades, experimentación con los enfoques disponibles y evaluación de las tecnologías emergentes. Con suerte, el ciclo permitirá pasar por las etapas cada vez más rápidamente aplicando las lecciones aprendidas en los esfuerzos anteriores.

What do you think?

Estoy totalmente de acuerdo con el enfoque según lo cual hay que «Pensar a lo grande, pero comenzar por lo pequeño». Muchos proyectos con grandes posibilidades de éxito fracasan simplemente porque no se entendieron los limites hasta donde se podía intentar llegar. En los big data imagino que sea exactamente lo mismo. Hay que tener conocimientos técnicos pero también pensamiento critico.