Aquí está mi opinión sobre las 10 tecnologías de datos más relevantes basadas en el análisis de Forrester:

Aquí está mi opinión sobre las 10 tecnologías de datos más relevantes basadas en el análisis de Forrester:

- Análisis predictivo: soluciones de software y / o hardware que permiten a las empresas descubrir, evaluar, optimizar e implementar modelos predictivos analizando grandes fuentes de datos para mejorar el rendimiento del negocio o mitigar el riesgo.

- Bases de datos NoSQL: bases de datos de valores clave, documentos y gráficos.

- Búsqueda y descubrimiento de conocimientos: herramientas y tecnologías en modo de autoservicio para apoyar la extracción de información y nuevos conocimientos a partir de grandes repositorios de datos no estructurados y estructurados que residen en múltiples fuentes, como sistemas de archivos, bases de datos, flujos, APIs y otras plataformas y aplicaciones.

- Stream analytics: software que puede filtrar, agregar, enriquecer y analizar un alto rendimiento de datos en vivo de múltiples fuentes de datos dispares y en cualquier formato de datos.

- Tejido de datos en memoria: tecnología que proporciona acceso de baja latencia y procesamiento de grandes cantidades de datos mediante la distribución de datos a través de la memoria dinámica de acceso aleatorio (DRAM), Flash o SSD de un sistema de computación distribuido.

- Almacenes de archivos distribuidos: una red de ordenadores donde los datos se almacenan en más de un nodo, a menudo de forma replicada, para optimizar redundancia y rendimiento.

- Virtualización de datos: una tecnología que proporciona información de varias fuentes de datos, incluyendo grandes repositorios de datos como Hadoop y almacenes de datos distribuidos en tiempo real y casi en tiempo real.

- Integración de datos: herramientas para la orquestación de datos a través de soluciones como Amazon Elastic MapReduce (EMR), Apache Hive, Apache Pig, Apache Spark, MapReduce, Couchbase, Hadoop y MongoDB.

- Preparación de datos: software que alivia la carga de abastecer, dar forma, limpiar y compartir conjuntos de datos diversos y desordenados para acelerar la utilidad de los datos para el análisis.

- Calidad de los datos: productos que realizan la limpieza y el enriquecimiento de datos en conjuntos de datos grandes y de alta velocidad, utilizando operaciones paralelas en almacenes de datos distribuidos y bases de datos.

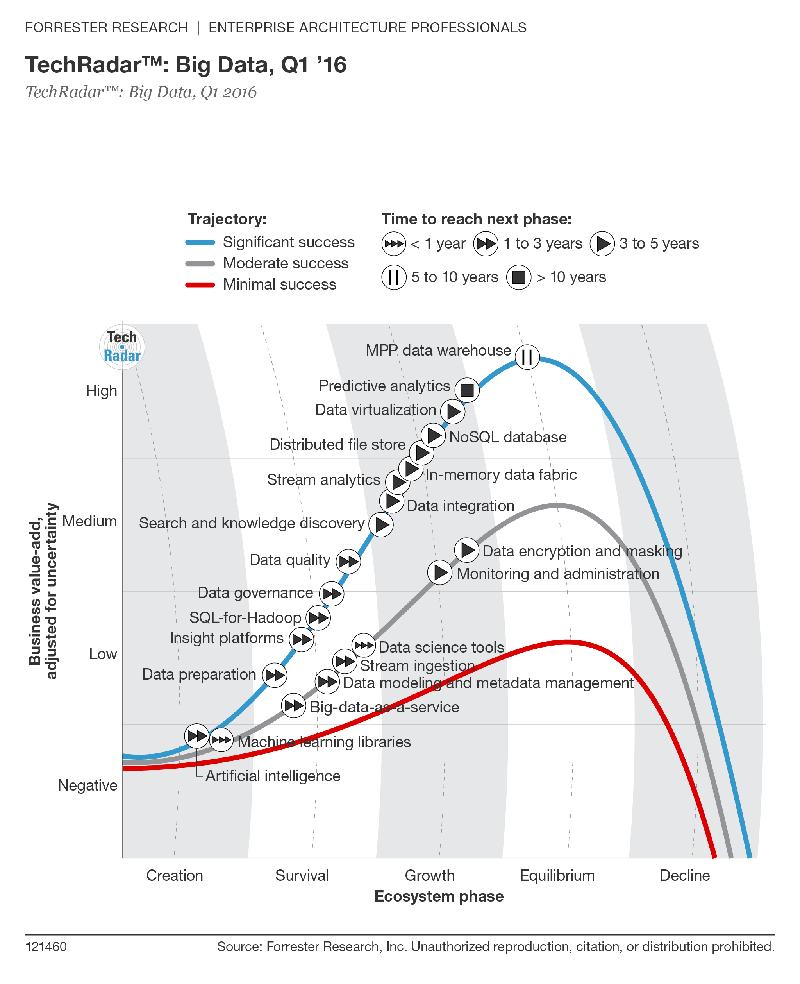

La metodología TechRadar de Forrester evalúa el éxito potencial de cada tecnología y se estima que las 10 tecnologías anteriores van a tener un «éxito significativo». Además, cada tecnología se coloca en una fase de madurez específica, desde la fase de creación, pasando por la maduración, hasta la disminución, en función del nivel de desarrollo de cada tecnología en el ecosistema. Las primeras 8 tecnologías de la lista se consideran que están en la etapa de crecimiento y las 2 últimas en la etapa de supervivencia.

Forrester también estima el tiempo que le llevará a cada tecnología llegar a la siguiente etapa. La analítica predictiva es la única con una designación de «10 años», ya que se espera que «entregue un alto valor de negocio en la fase de crecimiento durante mucho tiempo». Se espera que las Tecnologías 2 (noSQL) y 8 (integración de datos) alcancen la siguiente fase entre tres y cinco años, y se espera que las dos últimas tecnologías pasen de la supervivencia a la fase de crecimiento entre uno y tres años.

Finalmente, Forrester ofrece para cada tecnología una evaluación de su valor agregado de negocio, ajustado con la variable incertidumbre.Esto se basa no sólo en el impacto potencial, sino también en la retroalimentación, la evidencia de las implementaciones y la reputación del mercado. Según Forrester: «Si la tecnología y su ecosistema están en una fase temprana de desarrollo, debemos asumir que su potencial de impacto y disrupción es mayor que el de una tecnología mejor conocida». Las dos primeras tecnologías de la lista anterior están calificadas como de «alto» valor agregado de negocio, las dos siguientes como «medio», y el resto «bajo», sin duda debido a su estado emergente y la falta de madurez.

¿Por qué he añadido a la lista de las tecnologías que más debemos tener los ojos puestos dos que todavía están en la fase de supervivencia (preparación de datos y calidad de los datos)? En el mismo informe, Forrester también proporciona los siguientes datos de su encuesta del Q4 de 2015 entre 63 grandes proveedores de big data:

¿Cuál es el nivel de interés del cliente en cada una de las siguientes capacidades?

- Preparación y descubrimiento de datos: 52%

- Integración de datos: 48%

- Análisis avanzado: 46%

- Análisis de clientes: 46%

- Seguridad de datos: 38%

- Computación en memoria: 37%

Aunque Forrester predice que sobrevivirán unos cuantos proveedores independientes de preparación de datos, cree que esto es «una capacidad esencial para lograr la democratización de los datos», o más bien su análisis, permitiendo a los científicos de datos dedicar más tiempo a modelar y descubrir ideas, y permitir a los usuarios de negocio participar en la minería de datos de una forma rápida y sencilla. En calidad de los datos se incluye la seguridad de los mismos, además de otras características que garantizan que las decisiones se basen en datos fiables y precisos. Forrester espera que «la calidad de los datos tenga un éxito significativo en los próximos años» a medida que las empresas formalicen un proceso de certificación de datos. Los esfuerzos de certificación de datos tratan de garantizar que los datos cumplen con los estándares esperados de calidad, seguridad, y el cumplimiento normativo que respalda la toma de decisiones, el desempeño, y los procesos empresariales.

Big Data como tema de conversación ha llegado a las audiencias generales probablemente mucho más que cualquier otra palabra de moda en cuanto a tecnología.Esto no ha ayudado precisamente a la discusión de este concepto tan amplio, definido para las masas como «el sistema nervioso del planeta» o simplemente como «Hadoop» para el público un poco más técnico. El informe de Forrester ayuda a aclarar el término, definiendo los grandes datos como un ecosistema de 22 tecnologías, cada una con sus beneficios específicos para las empresas y, a través de ellas, para los consumidores.

Del big data, específicamente uno de sus atributos, el del gran volumen, ha dado lugar recientemente a un nuevo tema general de discusión, la Inteligencia Artificial. La disponibilidad de conjuntos de datos muy grandes es una de las razones por las que Deep Learning, un subconjunto de AI, ha estado en el centro de atención, desde la identificación de gatos en Internet hasta derrotar a un campeón de Go. A su vez, la IA puede conducir a la aparición de nuevas herramientas para recolectar y analizar datos.

Según Forrester: «Además de más datos y más poder computacional, ahora hemos ampliado las técnicas analíticas como el aprendizaje profundo y los servicios semánticos para el contexto que hacen de la inteligencia artificial una herramienta ideal para resolver una amplia gama de problemas empresariales». Forrester está viendo que varias empresas nuevas ya ofrecen herramientas y servicios que intentan soportar aplicaciones y procesos con máquinas que imitan algunos aspectos de la inteligencia humana.

La predicción es siempre difícil, especialmente en tecnología donde todo avanza rápidamente, pero es una apuesta (relativamente) segura que la carrera tecnológica va a imitar elementos de la inteligencia humana. Liderados por Google, Facebook, Baidu, Amazon, IBM y Microsoft, todos con bolsillos muy grandes, será posible ese acercamiento y hará cambiar el concepto «big data» en un futuro muy cercano.

What do you think?

cual es el campo tecnologuico del analisisi de datos

Comments are closed.